シグモイド関数 (Sigmoid Function)

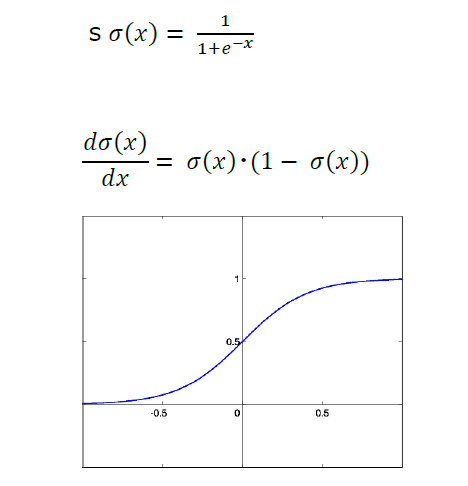

シグモイド関数 (Sigmoid Function) とは、下式で表されるS字型の滑らかな関数で、1980~2000年の深層学習研究の黎明期に活性化関数の主流の座を占めました。

入力xに対して出力が常に(0,1)の範囲に収まることから確率的な解釈が可能で、全値域で連続であることから勾配が計算可能です。また、微分がシンプルであることから勾配の計算が低コストでニューラルネットワークの学習において計算効率が良いとされます。

活性化関数として1980年代から2000年までの深層学習研究の発展に大きく貢献しましたが、深さのあるネットワークにおける勾配消失の問題から現在では限定的な用途でのみ利用され、現在ではReLU、Softmaxなどが主流の座を占めます。