勾配降下法(Gradient Descent)

勾配降下法とは、数学的最適化の手法の1つで、関数の極値(最小、または最大値)を見つけるために使用される手法です。

深層学習ではモデルの重さやバイアスのパラメータを最適化するために利用されます。

具体的には、誤差を最小化しモデルを最適化するために勾配降下法が利用されます。

パーセプトロンの重みw、とバイアスbは学習の各ステップnで以下のように更新されます。

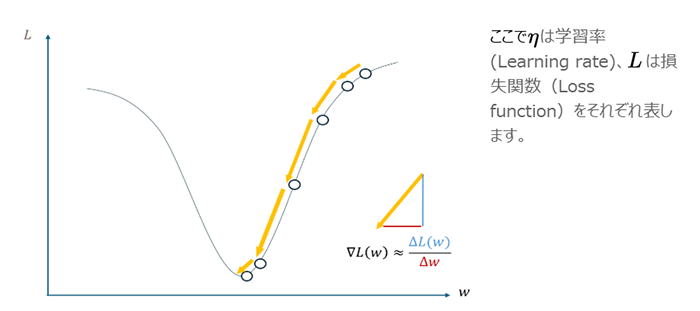

ここで、η は学習率(Learning rate)、L は損失関数(Loss function)をそれぞれ表します。

勾配降下法によるwの頂点(Lの極値)への漸近のイメージ