交差検証(Cross-Validation)

交差検証とは、広義には統計解析結果の妥当性を検証する手法です。

機械学習では予測モデルの汎化性能(未知のデータに対する予測力)の評価に利用します。

データセットをいくつかに分割し、それぞれを訓練データと検証データに見立て繰り返し評価します。

これにより、検証データの品質の影響を小さくし、より信頼できるモデルの性能評価ができます。

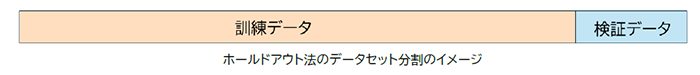

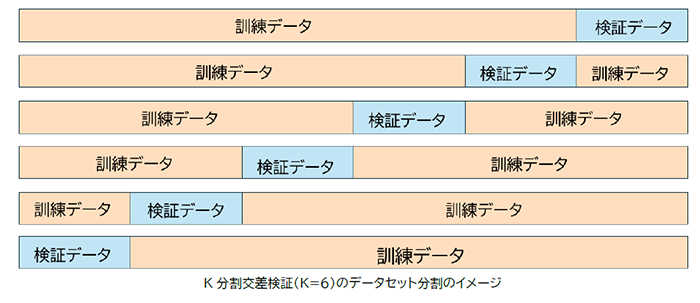

交差検証法の意義を想起するうえで、ホールドアウト法とK分割交差検証法の図による対比が簡明です。

ホールドアウト法

1回のみデータセットを訓練データと検証/テストデータに分割します。

K分割交差検証

検証データの品質の偏りをなくすためにデータをK個に分割して評価します。そのうち1つの分割データを検証データ、残りを訓練データとして評価します。

各分割データが検証データとなるよう、評価をK回繰り返します。それらの精度の平均値を最終的なモデルの評価とします。

その他の代表的な手法

交差検証はK分割交差検証以外にも精度・計算コスト・用途に応じて様々な手法が考案されており、以下に他の代表的な手法を挙げます。

- 層化K分割交差検証(Stratified K-Fold CV)

- リーブワンアウト法(Leave-One-Out Cross-Validation, LOOCV)

- シャッフル分割交差検証(Shuffle Split)

- 時系列交差検証(Time Series Split)

CAEのサロゲートモデル構築では、1回のモデル構築に時間がかかることがあることからホールドアウト法を用いざるを得ない場合があります。

その代わりにデータ分析など他のフェーズで検証データの偏りをなるべく小さくする努力が求められます。